近日,AI技术公司彩云科技发布了全新通用模型结构DCFormer,相关论文将在第41届国际机器学习大会ICML 2024正式发表。据一位评委透露,今年录用论文的平均分为4.25-6.33,而该论文获得平均7分。通过改进注意力机制,DCFormer相比Transformer性能提升1.7-2倍。在相同训练数据和算力下,用DCFormer改进后的69亿参数模型效果超过120亿参数模型。DCFormer模型代码、权重和训练数据集已开源发布,相关成果将陆续在彩云科技旗下产品彩云天气,以及小梦V4、小梦V5等模型上应用。

论文地址:

https://arxiv.org/abs/2405.08553

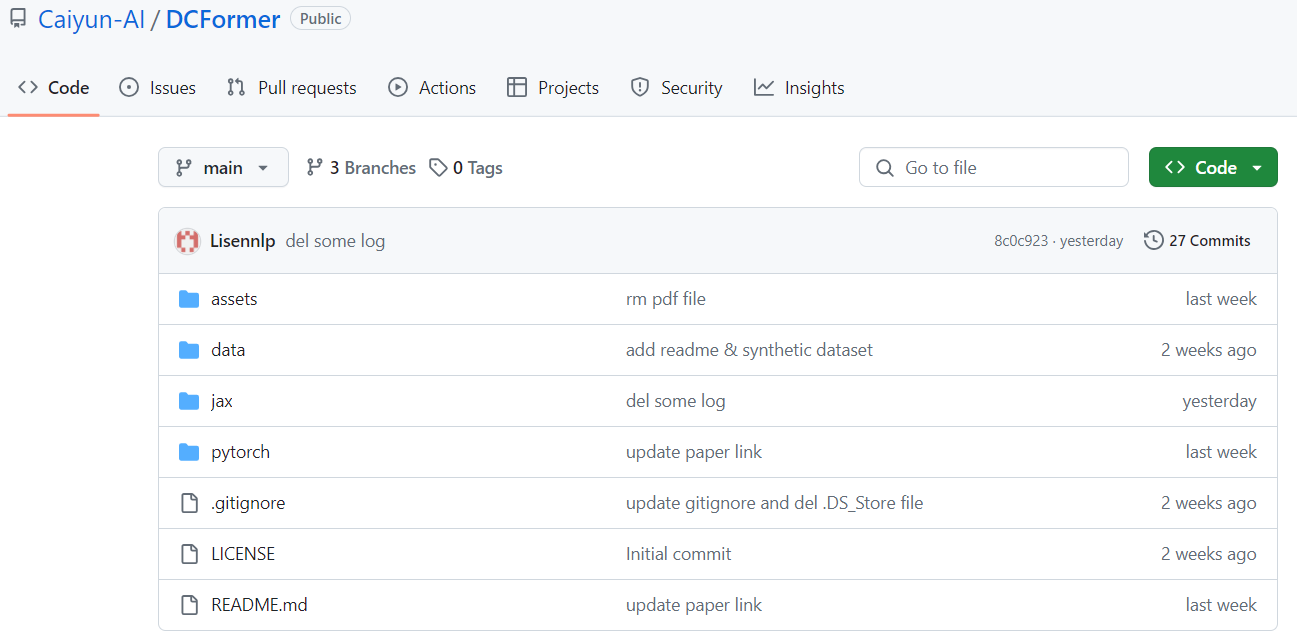

开源地址:

https://github.com/Caiyun-AI/DCFormer

-1.png)

一体式大规模多语言和多模式机器翻译模型,可为近 100 种语言的语音和文本提供高质量翻译。