项目简介

MiniCPM-V 是一系列端侧多模态大型语言模型(MLLMs),专为视觉-语言理解设计。该模型以图像和文本为输入,提供高质量的文本输出。自2024年2月以来,已发布了4个版本的模型,旨在实现强大的性能和高效的部署。

主要功能

多模态对话:支持图像和文本输入,进行多模态对话。

高分辨率图像处理:支持任意纵横比的高分辨率图像,最高可达1344x1344像素。

多语言支持:包括中文和英文在内的30多种语言的多模态对话支持。

高效部署:通过量化、编译优化和高效的推理技术,在端侧设备上实现高效部署。

使用方法

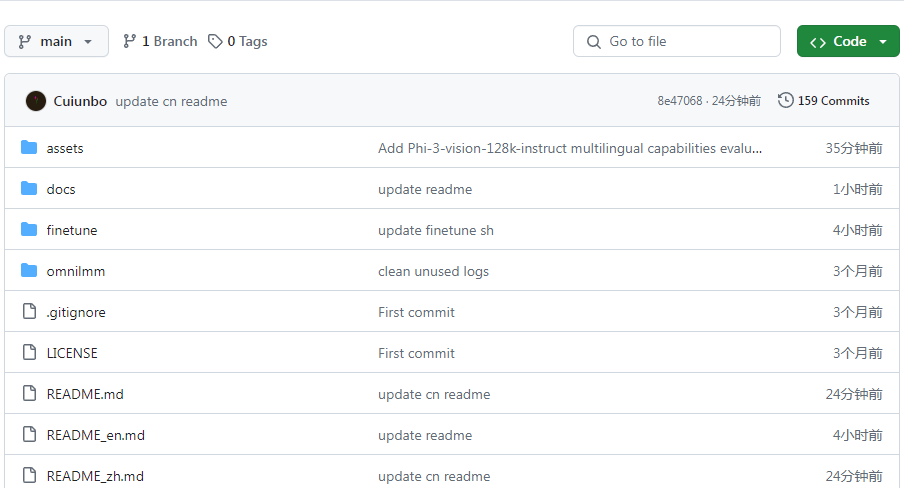

克隆 MiniCPM-V 的 GitHub 仓库并导航到源文件夹。

创建 Conda 环境并安装依赖。

根据项目中的指南进行模型的安装、推理和微调。

适用场景

视觉-语言任务:如图像描述、视觉问答等。

端侧设备部署:在手机或其他端侧设备上部署多模态模型。

多语言交互:支持多语言的对话和内容生成。

适用人群

AI 研究者和开发者,对多模态模型有兴趣的用户。

需要在端侧设备上进行多模态任务处理的应用开发者。

对人工智能和机器学习领域有兴趣的学者和学生。

优缺点介绍

优点

支持高分辨率图像和多语言,满足多样化需求。

高效部署能力,适用于端侧设备。

开源模型,易于获取和定制。

缺点

对于初学者,可能需要一定的学习和适应时间。

高级功能和微调可能需要深入理解模型和技术细节。

分类标签推荐

多模态模型、视觉-语言理解、端侧部署、多语言支持、人工智能

-1.png)

个性化解决方案,旨在生成一系列图像时保持多个角色场景中人物的面孔、服装、发型和身材的一致性,从而创建连贯的故事。